6.2. Annotation mit dem AdA-Template: Schritte und Arbeitsprozess#

Für die Arbeit mit dem AdA-Template muss Advene installiert sein und ausgeführt werden. Installationsanweisungen und Hinweise gibt unter Technische Voraussetzungen.

Übungsaufgabe

Ziel: Erstellen eines Annotationspaketes auf Basis der AdA-Ontologie mit dem AdA-Core-Template.

Aufgabe: Erstellen Sie ein Annotationspaket in Advene basierend auf der AdA-Ontologie. Nutzen Sie dafür das AdA-Core-Template, das bereits ein vordefiniertes Set an Annotationstypen enthält. Diese decken die wichtigsten Analysekategorien ab und erleichtern Ihnen den Einstieg. In den folgenden Abschnitten finden Sie eine detaillierte Beschreibung des gesamten Workflows mit präzisen Schritt-für-Schritt-Anweisungen.

Bearbeitungzeit: Ca. 180 Min.

6.2.1. Übungsanleitung: Grundlagen der ontologiebasierten Annotation mit Advene#

Einrichtung und Vorbereitung der Annotationsumgebung#

Installieren Sie Advene und laden sie das AdA-Template, die AdA-Filmontologie und das Manual herunter.

Starten Sie Advene. Wird die Developement-Version von Advene über eine virtuelle Maschine für Linux genutzt, muss einer dieser beiden Befehle im Ubuntu-Terminal eingegeben werden:

cd src/adveneoderGDK_BACKEND=x11 advene. Advene öffnet automatisch bei jedem Start ein neues Paket als advenespezifische .azp-DateiImportieren sie das AdA-Template (.azp-Datei) in das Paket und verknüpfen Sie das Video (Video: Ada-Template: Package, Manual: S. 4)

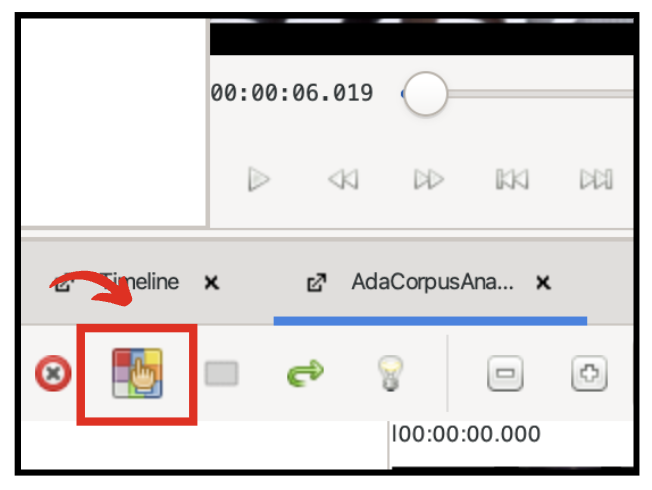

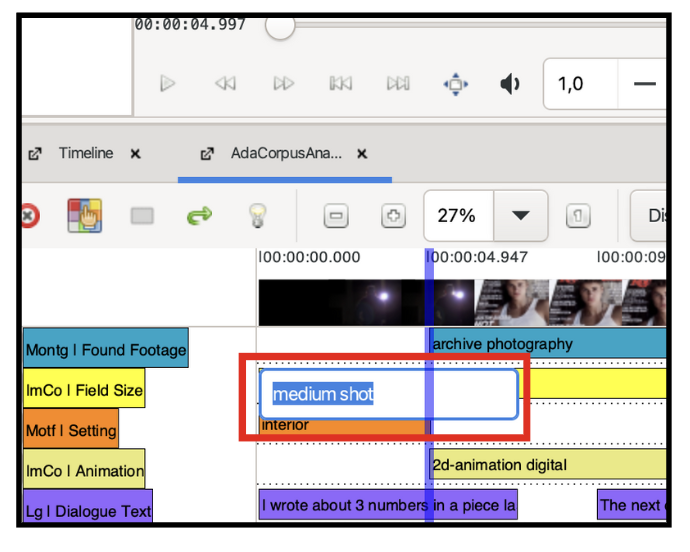

Öffnen Sie eine neue Timeline und integrieren Sie anschließend die AdA Corpus Analysis View als Annotationsgrundlage für die Spuren, die annotiert werden sollen. Unter folgendem Reiter können weitere vordefinierte Annotationstypen der Ontologie eingeblendet und andere ausgeblendet werden (Video: AdA Corpus Analysis View, Manual: S. 6ff)

Führen Sie die automatische Einstellungserkennung durch und validieren bzw. bereinigen Sie die Ergebnisse mit der Validation View. Anschließend müssen die Einstellungen renummeriert werden (Video: Process Video, Shot Validation & Subtitles, Manual: S. 116)

Welche Schritte müssen vollzogen werden, damit die automatischen Erkenneralgorithmen durchgeführt werden?

Antwort

Um die automatische Videoanalyse durchzuführen auf ‘File’ und ‘Process Video’ gehen. Anschließend öffnet sich der ‘Importer’. Unter ‘Filter’ werden Auswahloptionen angezeigt.

Warum müssen die Einstellungen renummeriert werden?

Antwort

Nicht jede Einstellungsgrenze wird korrekt gesetzt. Daher ist es notwendig mit der Shot Validation die Einstellungsgrenzen zu korrigieren. Dieser Schritt ist unerlässlich und bildet die Grundlage für alle weiteren Annotationsspuren, die nach dem Einstellungsprinzip annotiert werden. Nach der Bereinigung mit der Shot Validation sind die Einstellungsnummern i.d.R. nicht mehr korrekt. Diese müssen dann überprüft und angepasst werden.

Importieren Sie, sofern verfügbar, die Untertitel und ordnen Sie diese dem korrekten Annotationstyp zu. (Video: Importing Subtitles, Manual: S. 126ff)

Erstellung der Annotationen#

Erstellen Sie Annotationen als Zeiteinheiten entlang der Timeline und wenden Sie dabei, wie unten beschrieben, das korrekte Segmentierungsprinzip an. Ordnen Sie den Annotationen Werte zu - nutzen Sie dafür:

Short Cuts und Quick Fill für ontologiebasierte Einträge

Freitext-Eingaben für Werte ohne Ontologiebezug (Video: Annotate with Short Cuts, Manual: S. 69ff & 131ff)

Tipp

Für die Erstellung korrekter bzw. präsizer Start- und Endzeit der Annotationen kann die Wiedergabegeschwindigkeit angepasst und mit den Frame-Tasten gearbeitet werden.

Für einige Annotationstypen haben wir die Annotationen als Verläufe angelegt, für andere haben wir nach dem Einstellungsprinzip segmentiert. Folgende Tabelle soll als Annotationshilfe dienen:

Achtung

Diese Annotationssegmentierung kann von Gegenstand zu Gegenstand, je nach den Formen der Inszenierung, variieren. Für diese Übung soll die Tabelle lediglich als Orientierungshilfe dienen.

Segmentierung nach Einstellung |

Segmentierung nach Verlauf |

|---|---|

Shot (semi-automatische Generierung) |

Setting |

Shot Duration |

Found Footage |

Montage Figure Macro |

Animation |

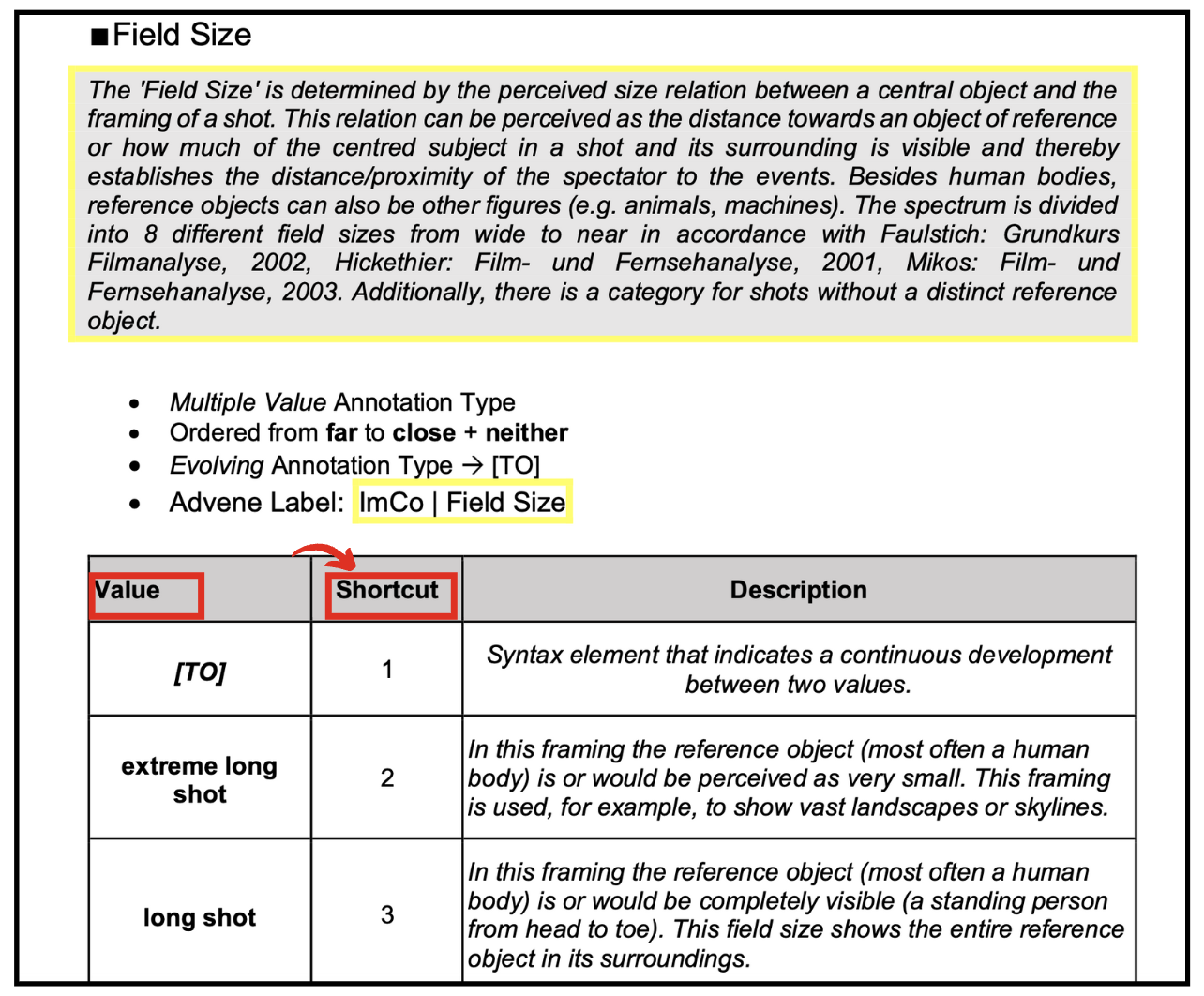

Field Size |

Dialogue Text |

Image Intrinsic Movement |

Image Brightness |

Image Content |

Colour Range |

Camera Angle |

Dominant Movement Direction |

Camera Movement Direction |

Recording/Playback Speed |

Body Language Emotion |

Dialogue Emotion |

Sound Gesture Dynamics |

|

Music Mood |

|

Montage Figure Macro |

Für einige Annotationstypen können Syntaxelemente verwendet werden. Was beschreiben die Werte [TO] sowie [VS] jeweils?

Antwort

[TO]: Beschreibt die Möglichkeit, ein Syntaxelement zu verwenden, das

eine kontinuierliche Entwicklung zwischen zwei Werten anzeigt.

[VS]: Beschreibt die Möglichkeit, ein Syntaxelement zu verwenden, das

zwei kontrastierende Werte verbindet.

Antwort

Die korrekte Antwort ist: 8

Die Verwendung von Syntaxelementen ermöglicht es kontinuierliche Entwicklungen wie auch synchrone Kontraste, die beispielsweise innerhalb einer Einstellung auftauchen, miteinander zu verbinden. Ein gutes Beispiel für für die Verwendung des Syntaxelement [TO] ist der Wechsel von Einstellungsgrößen innerhalb einer Einstellung. Ein gutes Beispiel für die Verwendung des Syntaxelement [VS] sind synchron inszenierte Dialog Emotionen bei mehreren Figuren innerhalb einer Einstellung.

Für folgende Annotationstypen des Core-Templates können Syntaxelemente verwendet werden:

Dialogue Emotion [VS]

Body Language Emotion [VS]

Recording/Playback Speed [TO]

Camera Angle [TO]

Field Size [TO]

Image Brightness [TO]

Image Intrinsic Movement [TO], [VS]

Dominant Movement Direction [TO], [VS]

Nutzen Sie die ‘Search/replace’-Funktion zur effizienten Übertragung von Segmentierungen

Überprüfen und bereinigen Sie Ihre Annotationen mit der Checker-Funktion (Video: Checker Function, Manual: S. 91ff)

Exportieren Sie Ihre Ergebnisse in ein geeignetes Dateiformat zur Visualisierung und weiteren Analyse (Video: Export & Visualization, Manual: S. 106ff & 133ff)